Voici Mistral AI, la start-up française capable de rivaliser avec OpenAI

Par June Cantillon - Publié le

Mistral AI : une start-up française avec le vent en poupe

Tout va très vite dans le milieu de l'IA, tout du moins lorsque les bonnes personnes travaillent ensemble. Jugez plutôt, la start-up Mistral AI a été fondée en mai dernier par trois anciens de Polytechnique et de l'Ecole Normale Supérieure et vient d'annoncer le 10 décembre avoir levé quelque 385 millions d'euros, pour une valorisation qui atteint déjà presque 2 milliards d'euros ! Une nouvelle licorne française vient donc de voir le jour. Selon Arthur Mensch, le dirigeant de la firme :

Depuis la création de Mistral AI en mai, nous suivons une ambition claire : créer un champion européen à vocation mondiale dans l’intelligence artificielle.

Arthur Mensh, ayant œuvré chez DeepMind, la division IA de Google, n'est pas seul puisqu'il est épaulé par deux autres cofondateurs de talent, Timothée Lacroix ancien chercheur chez Meta, et Guillaume Lample, un des créateurs du modèle LLama de Meta, ainsi qu'une équipe de 22 employés. Parmi les soutiens de Mistral AI, on compte du beau monde, dont Xavier Neil, Eric Schmidt, Nvidia, BNP Paribas, ou encore CMA CGM.

Un modèle capable de rivaliser avec GPT-3.5

Le modèle Mixtral 8x7B, le plus évolué de la start-up, est un modèle ouvert

MoEpour Mixture of Experts, un système distribuant les données à des réseaux neuronaux spécialisés, contrairement au Gemini de Google par exemple. Le modèle fonctionne en Français, allemand, espagnol, italien et anglais. et peut rouler en local sur un Mac M1.

Cette technique augmente le nombre de paramètres d'un modèle tout en contrôlant le coût et la latence, car le modèle n'utilise qu'une fraction de l'ensemble total de paramètres par token. Concrètement, Mixtral a 46,7 milliards de paramètres au total mais n'utilise que 12,9 milliards de paramètres par token. Il traite donc les entrées et génère la sortie à la même vitesse et pour le même coût qu'un modèle 12,9B.

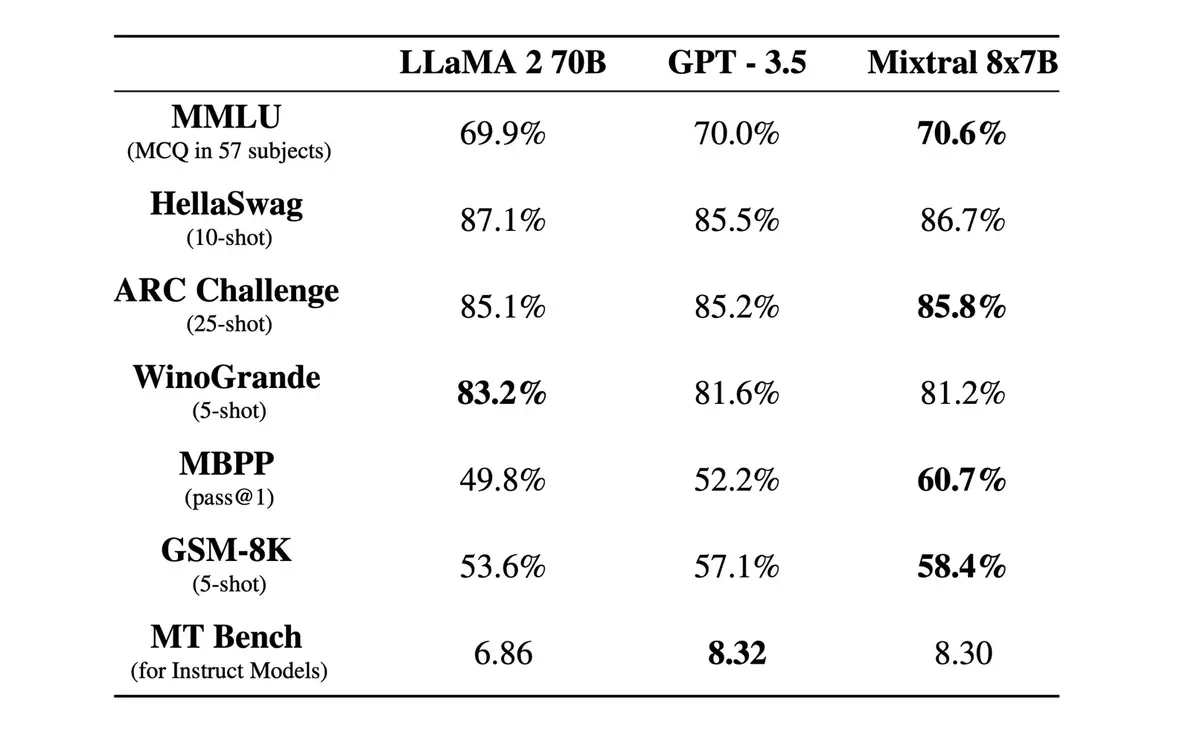

Mistral 8x7B semble déjà très efficace malgré son jeune âge, et, comme vous pouvez le constater sur le tableau ci-dessus, rivalise avec LLama 2.70B de Meta et GPT-3.5 d'OpenAI sur certains benchmarks. La start-up avec laquelle il va falloir compter entend bien faire de gros progrès dans les mois à venir et proposer rapidement une offre commerciale.

Nous nous engageons à sortir les modèles ouverts les plus performants parallèlement au développement de notre offre commerciale. Nous proposerons des modèles propriétaires optimisés pour le déploiement sur site/cloud privé virtuel. Nous travaillons activement sur des solutions hébergées et un déploiement dédié pour les entreprises.

Nous formons déjà des modèles beaucoup plus grands et nous nous tournons vers de nouvelles architectures.