OpenAi promet de surveiller les IA dangereuses (est-ce vraiment possible ?)

Par Laurence - Publié le

La nécessite de mieux encadrer l'IA

Le travail de cette équipe (en vo

preparedness team) sera d'évaluer chaque nouveau nouveau modèle d'IA et d'en surveiller le lancement, quitte à demander sa suspension s'il est considéré comme trop dangereux. Pour cela, elle s'appuiera sur des process et des niveaux de risques qui ont été définis dans un document publié lundi.

- la cybersécurité et la capacité du modèle à procéder à des attaques informatiques d'ampleur,

- la mesure de la propension du logiciel dans le cadre de la création d'un mélange chimique, d'un organisme (par exemple un virus) ou d'une arme nucléaire, globalement tous éléments pouvant être nocifs pour l'homme et le vivant,

- la capacité de persuasion du modèle (déterminer dans quelle mesure il peut influencer des comportements humains),

- l'autonomie potentielle du modèle (vérifier notamment s'il peut s'exfiltrer / échapper au contrôle de ses créateurs).

Une fois les risques identifiés, un rapport sera transmis au Safety Advisory Group, un conseil de sécurité qui effectuera des recommandations à Sam Altman ou à une personne désignée par lui. Ce dernier décidera alors des possibles modifications à apporter. Enfin, cette équipe sera placée sous la surveillance du chercheur en informatique Aleksander Madry, qui travaille habituellement au Massachusetts Institute of Technology (MIT).

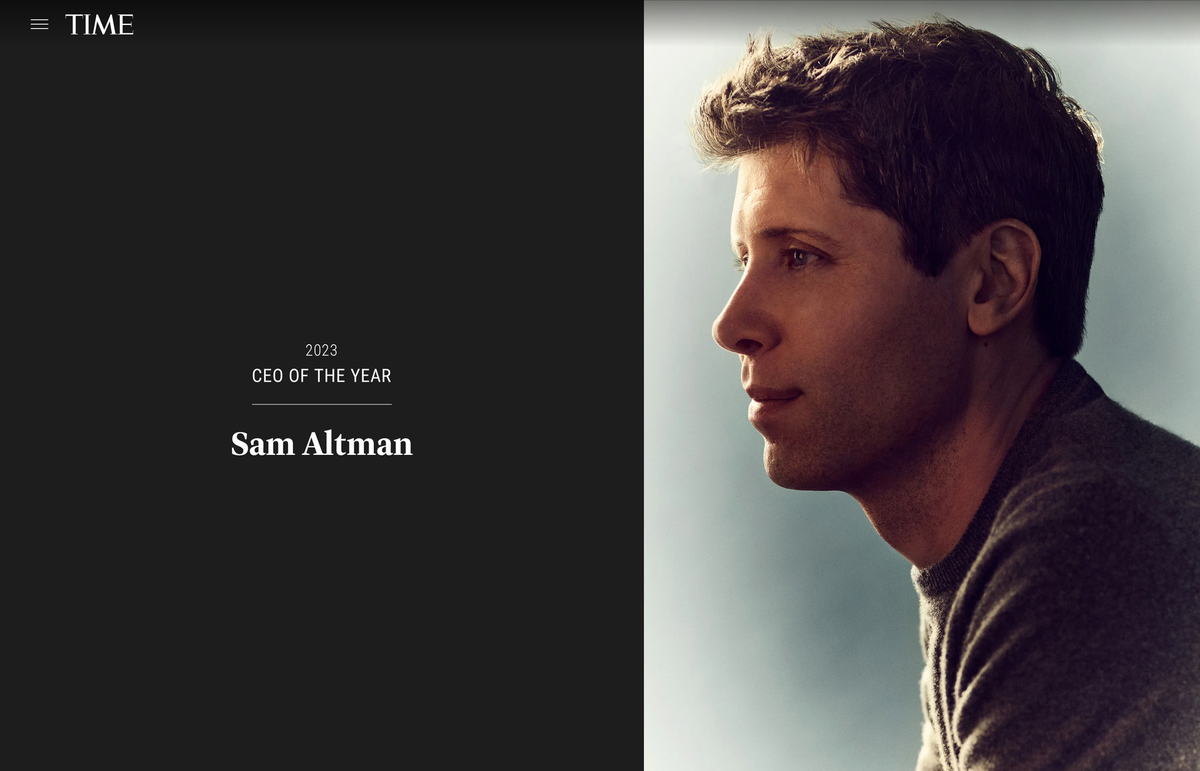

Sam Altman, le ceo de l'année

Notons que cette annonce se fait juste après les mésaventures très médiatiques de Sam Altman dont l'éjection du fauteuil de CEO d'OpenAI n'a duré que quelques jours (certaines mauvaises langues diraient :

juste le temps de vendre les droits à une plateforme de streaming).

Il lui était alors rapproché de privilégier un développement accéléré d'OpenAI quitte à éluder certaines interrogations sur les possibles dérives de l'IA. En attendant, cela n'a pas empêché Sam Altman d'être désigné CEO de l'année par le TIME.