Plus besoin de parler ! Siri va pouvoir lire sur les lèvres

Par Laurence - Publié le

de nouvelles capacités de détection pour Siri

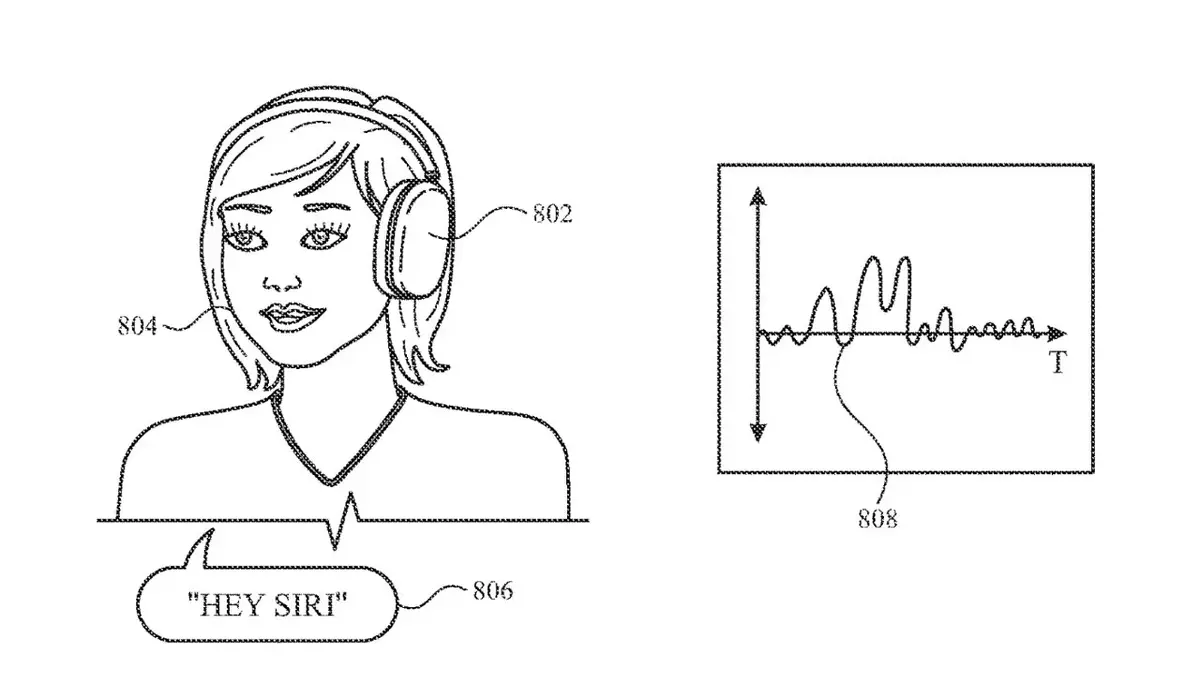

D'après ce document intitulé

"Keyword Detection Using Motion Sensing", l'assistant d'Apple -souvent critiqué pour son manque de compétences et d'améliorations dans le temps face à la concurrence- pourrait être en mesure de récupérer de nouveaux pouvoirs de détection. Ainsi il pourrait lire sur les lèvres, et exécuter des commandes, sans avoir besoin de prononcer un seul mot ! Plutôt pratique !

A cela s'ajouterait d'autres fonctionnalités, comme la capacité de détecter et analyser des mouvements de la bouche et de la tête pour améliorer sa précision. Cette demande de brevet nouvellement révélée, vise à le faire - mais ensuite quelque chose de plus.

Comment cela fonctionne-t-il ?

D'après le brevet,

[les données] sont reçues d'un capteur de mouvement, par exemple, en enregistrant le mouvement d'un utilisateur [...] Il est déterminé si une partie des données de mouvement correspond aux données de référence pour un ensemble d'un ou plusieurs mots (par exemple, un mot ou une phrase).Pour limiter les erreurs, Siri pourrait coupler ces signes de tête avec des

mouvements de la bouche, et inversement.

Mais Siri pourrait utiliser les autres capteurs de l'iPhone :

quand un utilisateur parle, la bouche, le visage, la tête et le cou de l'utilisateur bougent et vibrent, les capteurs de mouvement tels que les accéléromètres et les gyroscopes peuvent détecter ces mouvements, tout en dépensant relativement peu de puissance par rapport aux capteurs audio tels que les microphones.

On pourrait enfin imaginer Siri emprunter le module de reconnaissance faciale de l'iPhone pour affiner l'analyse !