TrueDepth et IA : le futur du HomePod pourrait passer par la reconnaissance gestuelle

Par Laurence - Publié le

Dans cette même optique, l’USPTO vient de publier un brevet pour un

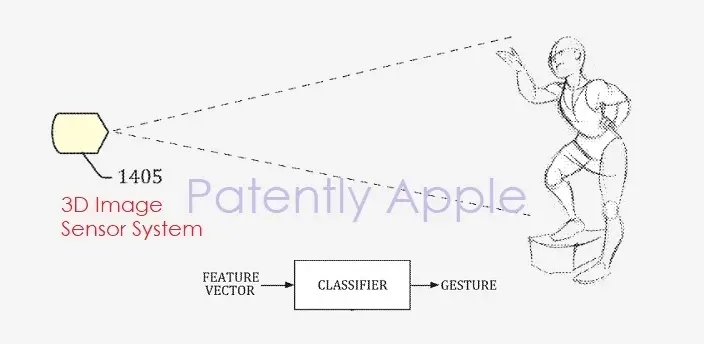

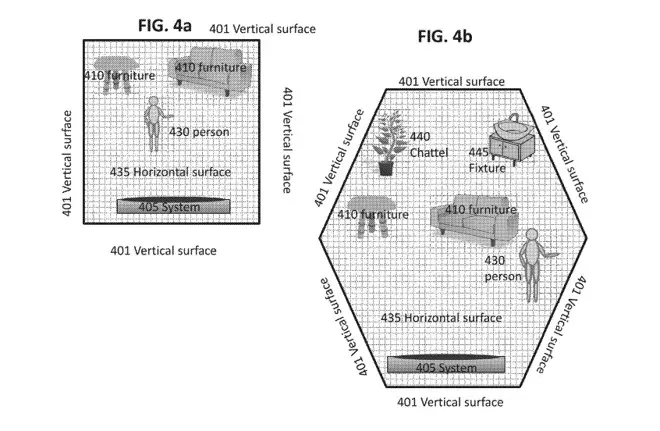

système informatique ou de divertissement multimédia pour répondre à la présence et à l’activité des utilisateurs. Et plus précisément, comment utiliser en temps réel, les données des capteurs tridimensionnelles pour faire fonctionner un HomePod ou un autre appareil.

Comme il est courant, le document se veut extrêmement complexe (un des plus poussés d'Apple en la matière) expliquant l'utilisation des données pour créer une carte 3D d'une pièce, mise à jour en temps réel en fonction des déplacements des personnes ou des objets. En théorie, le système se livrerait à des comparaisons constantes entre la réalité et sa base de donnée. La technique permettrait ainsi de détecter les mains d'un utilisateur, en segmentant la zone de cartographie globale et attribuant certaines actions à des gestes.

Selon Apple, les systèmes de reconnaissance gestuelles sont encore à un stade "larvaire" et ne parviendraient pas à distinguer les différentes parties de la main, comme les doigts et leur orientation. Précisons que ce nouveau dispositif semble intégrer la technologie TrueDepth de l'iPhone X (acquise par Cupertino avec la firme PrimeSense en 2013) mais également les connaissances IA de la société LinX (une autre acquisition de 2015). Dans ses derniers travaux, on remarque une place prépondérante accordée aux gestes - plus qu'à la voix- et certaines rumeurs circulent sur d'autres fonctionnalités de Siri. Enfin, pour l'instant on aimerait juste qu'il fonctionne un peu mieux à la voix...

Source