Apple veut faire rentrer son ChatGPT au chausse-pied dans l'iPhone

Par June Cantillon - Publié le

Apple GPT sur un iPhone ?

Plusieurs fuites ont permis de savoir qu'Apple planchait activement sur l'intégration des grands modèles de langage au sein de ses différents systèmes. Les équipes de Cupertino seraient actuellement en train d'élaborer un robot conversationnel et un grand modèle de langage capable de rivaliser avec ChatGPT d'OpenAI, Gemini de Google et autre LLaMA 2 de Meta. Si Apple n'entend pas se laisser distancer sur ce marché porteur, la firme ne compte certainement pas écorcher son image basée sur le respect de la confidentialité, et devrait donc tenter de faire tourner son grand modèle de langage en local, notamment sur les iPhone.

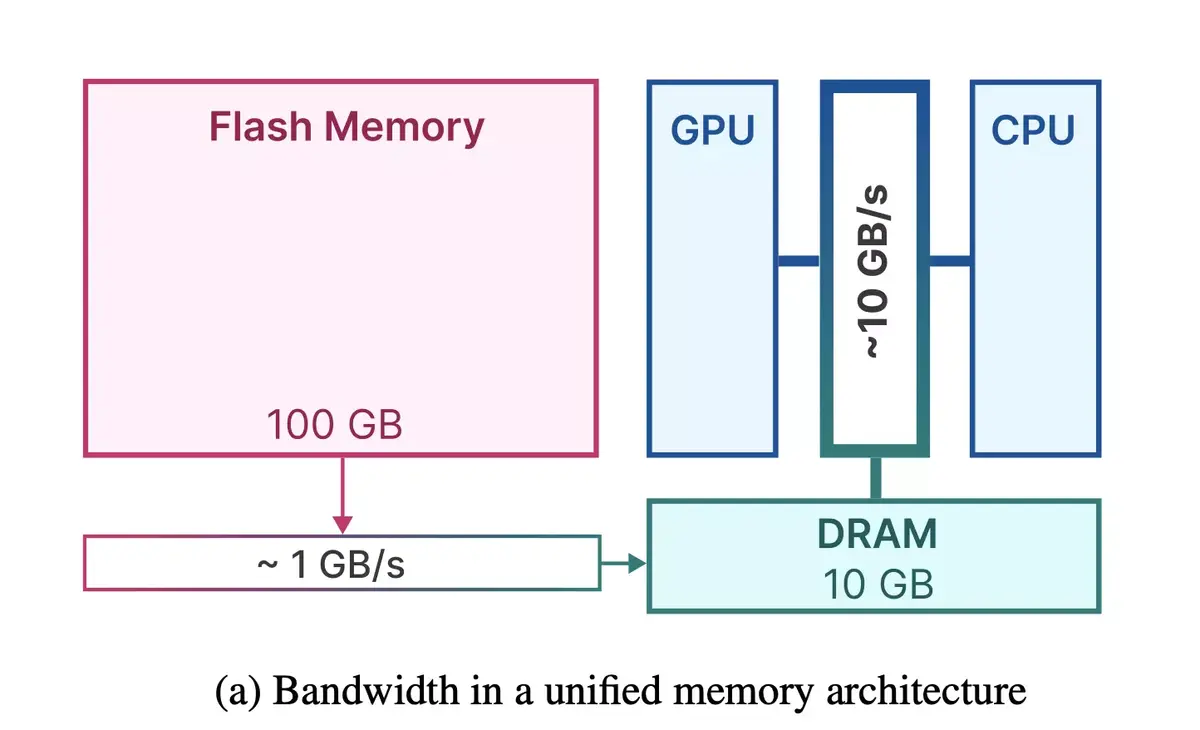

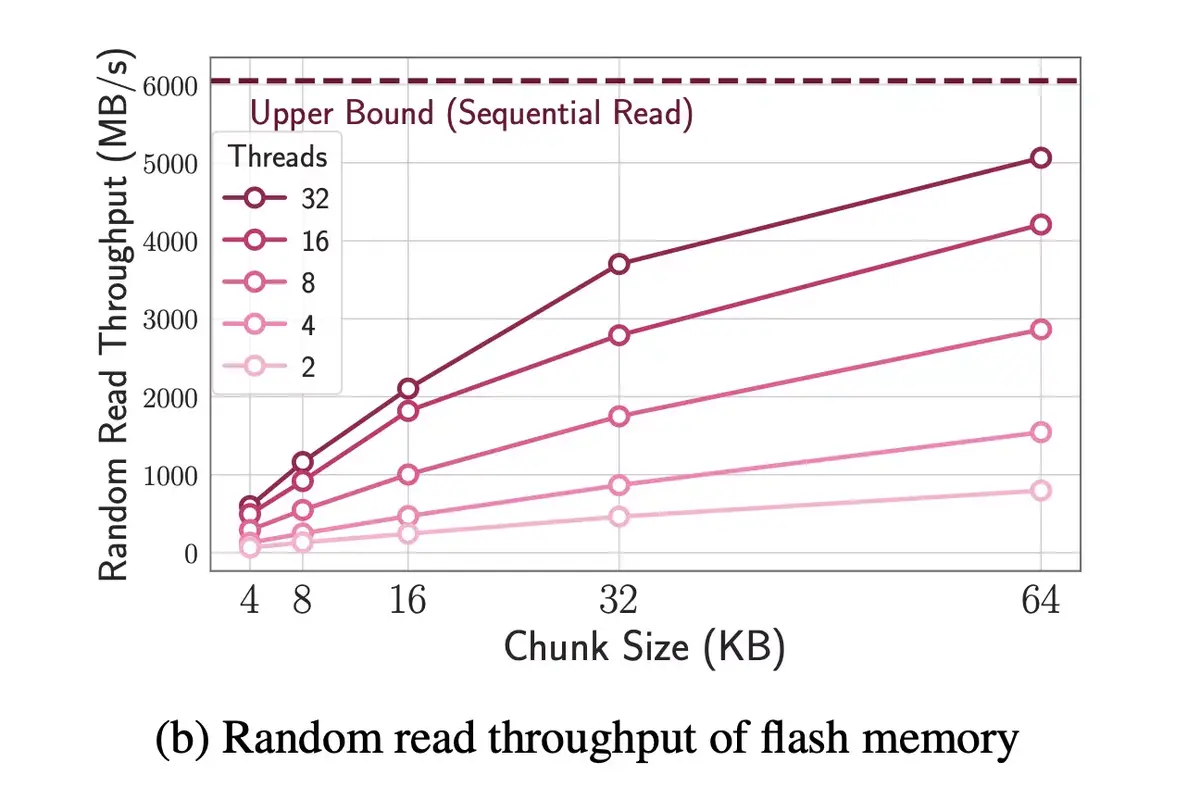

Les grands modèles de langage sont toutefois gourmands en RAM, et Apple va devoir trouver un moyen de faire fonctionner sa technologie sur ses smartphones qui ne sont pas dotés de grandes quantités de mémoire. Cupertino a justement publié des travaux sur le sujet. Intitulé LLM in a flash, ce document évoque la possibilité d'utiliser le stockage interne des appareils, nettement plus important (mais il faudra alors réserver une partie du stockage pour cet usage), tout en limitant l'usage de la RAM, notamment grâce aux techniques de

Windowinget de

Row-Column Bundlingdécrites au sein du dossier.

Contourner le manque de RAM

En combinant ces deux méthodes, Apple parviendrait non seulement à contourner le souci du manque de mémoire en utilisant des modèles prenant deux fois plus de place que la quantité de RAM disponible, mais également d'obtenir un traitement performant. Le document évoque un traitement 4 à 5 fois plus rapide en utilisant le CPU et 20 à 25 fois plus rapide via le GPU que la méthode traditionnelle.

Apple pourrait donc s'appuyer sur ces travaux pour proposer un traitement en local, respectant ainsi la sacro-sainte confidentialité des données de ses utilisateurs, ainsi que des performances satisfaisantes. Reste à savoir quand et comment Apple se lancera dans la bataille des robots conversationnels (aurons-nous un Siri enfin performant ?), et à quel niveau se situera son modèle par rapport à la concurrence