Cette option n'a jamais été déployée par Apple, 2 680 personnes l'attaquent en justice !

Par Laurence - Publié le

Une action en justice pour une option qui n'a jamais été déployée !

Mais il semblerait que le dossier du CSAM ne soit pas encore archivé avec ce procès, qui soulève des questions complexes sur l’équilibre entre la confidentialité des utilisateurs et la protection des enfants en ligne.

Pour cela, il faut remonter à l'origine de la fonction. En août 2021, la firme californienne avait été très critiquée lors de la présentation de son système CSAM -Child Sexual Abuse Material- et elle avait été amenée à suspendre sa mise en place en décembre. A cette époque, elle avait dans la plus grande discrétion enlevé toutes les mentions relatives au CSAM, confirmant la controverse autour des mesures envisagées.

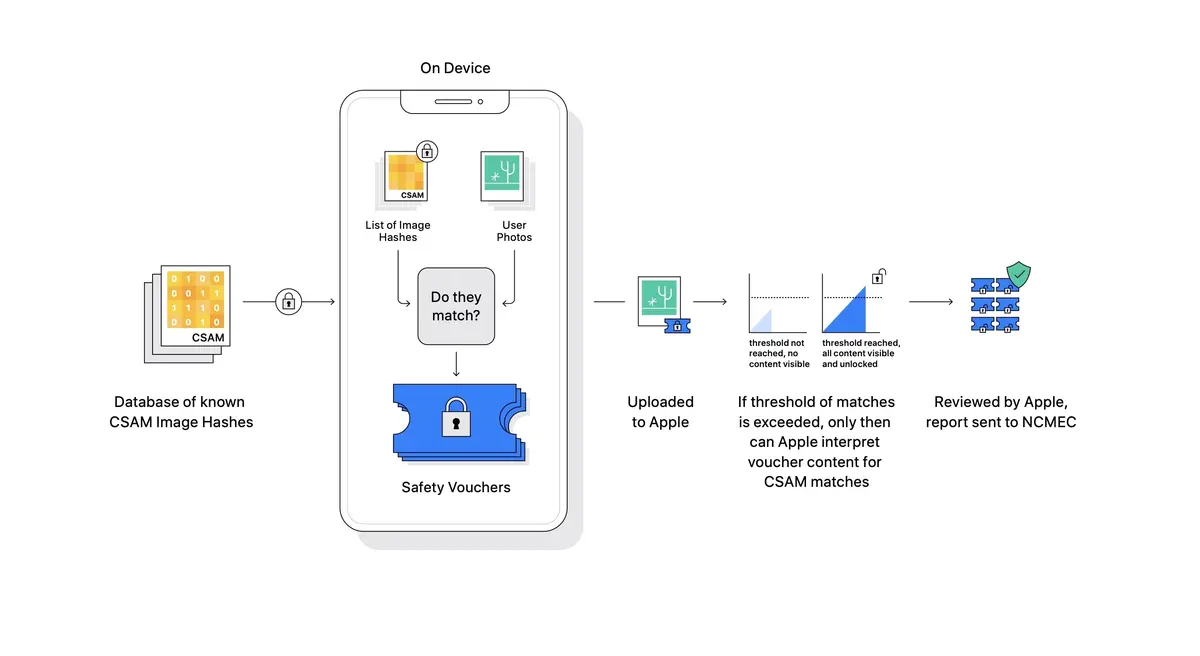

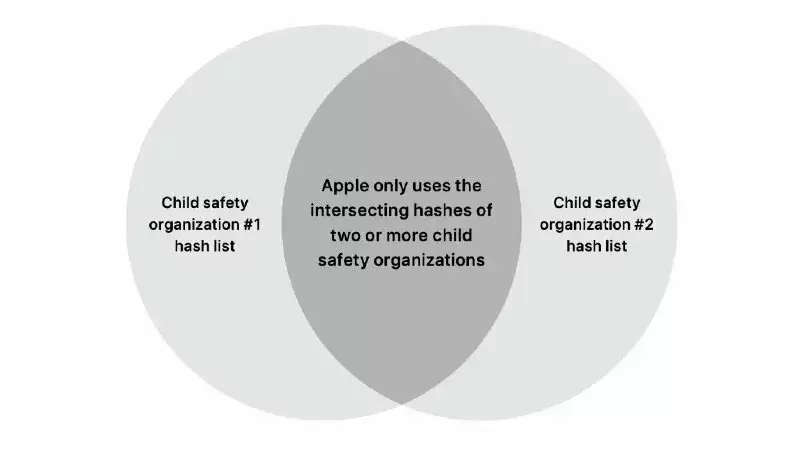

Globalement, il s'agissait de fonctionnalités sur ses plateformes visant à protéger les enfants, y compris un système capable de détecter les contenus pédo-pornographiques dans iCloud tout en préservant la confidentialité des utilisateurs. Ces dernières regroupaient trois domaines : iMessage, Siri, iCloud. Très rapidement dénommée

scan de l'iPhone, la fonction avait déclenché un tollé d'opposition de la part des utilisateurs, des officiels ou des chercheurs en sécurité.

Face aux critiques, Apple a d’abord reporté, puis annulé ce projet. La décision a été motivée par des inquiétudes concernant la sécurité, la vie privée des utilisateurs et le risque d’exploitation de cette technologie pour d’autres types de surveillance.

Quelles sont les demandes ?

Le procès est intenté au nom de 2 680 victimes potentielles d’abus, affirmant qu’Apple a permis au contenu CSAM de continuer à circuler en ligne. Pour la principale demanderesse, déposant sous un pseudonyme (cela est possible aux USA), l’inaction d’Apple aurait prolongé son traumatisme en permettant à des images de son exploitation passée de rester accessibles.

Globalement, les requérants soutiennent qu’en abandonnant ses outils de détection CSAM, Apple a failli à son devoir de protéger les enfants et les victimes d’abus. Et par conséquent, que le non-déploiement de cette technologie dans iCloud Photos a directement contribué à la diffusion de contenu nuisible.

De son côté, Apple a réaffirmé son engagement à protéger les enfants, tout en défendant son choix de ne pas introduire une technologie qui pourrait compromettre la vie privée des utilisateurs. La firme a ainsi mis en avant ses outils actuels, tels que la fonction de sécurité des communications pour avertir les enfants du contenu potentiellement inapproprié.

Trop de risque pour la confidentialité des données

Après sa décision de ne pas déployer cette fonction, Apple était venue s'expliquer davantage, répondant à une demande de l'association Heat Initiative, et ce, par l'intermédiaire d'Erik Neuenschwander (Apple’s director of user privacy and child safety).

L'abus sexuel des enfants est un acte odieux et nous nous engageons à briser la chaîne de coercition et d'influence rendant les enfants vulnérables. [...] La numérisation des données iCloud stockées pour chaque utilisateur individuel créerait de nouveaux vecteurs de menace que les voleurs de données pourraient trouver et exploiter[...] Cela pourrait nous amener sur une pente glissante avec des conséquences imprévues. La recherche d'un type de contenu ouvre la porte à la surveillance en masse et pourrait donner l'envie de rechercher d'autres systèmes de messagerie chiffrées.(Erik Neuenschwander, Apple’s director of user privacy and child safety)

Autrement dit après avoir mis les intérêts dans la balance, l'ingérence dans la vie privée et le risque de piratage de données (donc d'affaiblir la sainte sécurité d'Apple) étaient trop importants. Aussi il convenait de trouver un autre moyen tendant vers la lutte contre la pédo-pornographie. Aussi, elle en a conclu qu'elle ne pouvait pas procéder au développement d'un mécanisme d'analyse comme le CSAM.

Cette réponse intervient à un moment tendu où le débat sur le chiffrement a été relancé par le gouvernement britannique. Ce dernier envisage de modifier son régime légal pour obliger les entreprises techs à désactiver les fonctionnalités de sécurité comme le chiffrement de bout en bout, et ce, sans en informer les utilisateurs (sous certaines conditions). Dans ces conditions, Apple avait précisé qu'elle retirerait ses services, y compris FaceTime et iMessage, au Royaume-Uni si une telle loi était adoptée dans sa forme actuelle.