Adobe ou les CGU de la discorde. La polémique continue

Par Laurence - Publié le

Une polémique qui se durcit

Le contexte est très tendu depuis que l’éditeur a annoncé la possibilité d’accéder aux contenus hébergés sur le cloud. Bien sûr cet accès n’est pas systématique, mais répond à des conditions précises -la lutte contre la pédopornographie et les contenus pénalement répréhensibles- mais le procédé n’est pas acceptable pour de nombreux utilisateurs.

Dans une nouvelle tentative d’éclaircissement, l’éditeur a précisé :

Adobe accède au contenu de l'utilisateur pour un certain nombre de raisons, y compris la possibilité de fournir certaines de nos fonctionnalités les plus innovantes basées sur le cloud, telles que les filtres neuronaux Photoshop et Supprimer l'arrière-plan dans Adobe Express, ainsi que de prendre des mesures contre le contenu interdit. ../.. Adobe n'accède pas, ne consulte ni n'écoute le contenu qui est stocké localement sur l'appareil d'un utilisateur.

De même, Adobe a rajouté qu’elle ne formait pas les modèles Firefly Gen AI sur le contenu client et qu’elle n'assumera jamais la propriété du travail d'un client. Malheureusement ces précisions ne permettent pas de répondre aux questions, et ne précise pas les conditions de formation de l'IA (il n’y a pas qu’une IA chez Adobe et cela peut être une autre IA que Firefly qui va venir contrôler les contenus). De même l’appropriation des contenus ne faisait pas partie de la polémique, mais on peut désormais se demander pourquoi l’éditeur a fait cette précision.

Rappel

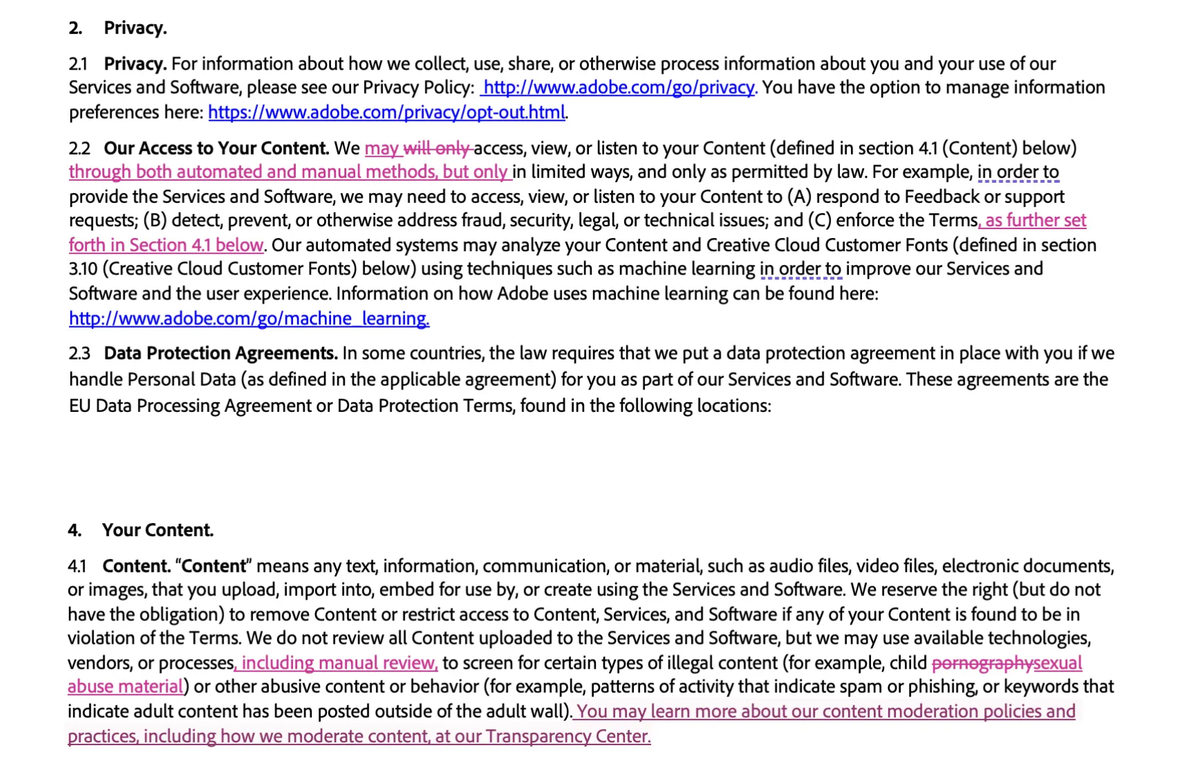

Mais, en regardant de plus près, la rédaction des CGU implique a contrario à l'éditeur d'accéder aux contenus via des technologies informatiques ou des interventions humaines. Est également évoqué la possible d'accéder, regarder ou écouter les contenus, certes dans les limites autorisées par la loi mais cela veut dire là encore que l'éditeur y a accès.

De même, Adobe dit qu'il pourrait avoir besoin d'accéder au contenu d'un utilisateur pour

répondre aux commentaires ou aux demandes d'assistance. Il peut également le faire

pour détecter, prévenir ou traiter de toute autre manière les problèmes de fraude, de sécurité, juridiques ou techniques. Les termes sont suffisamment larges et imprécis pour satisfaire les utilisateurs et les rassure face à l’émergence de l’IA.