ChatGPT est né sur un superordinateur à plusieurs centaines de millions de dollars

Par June Cantillon - Publié le

Un supercalculateur chez Microsoft pour ChatGPT

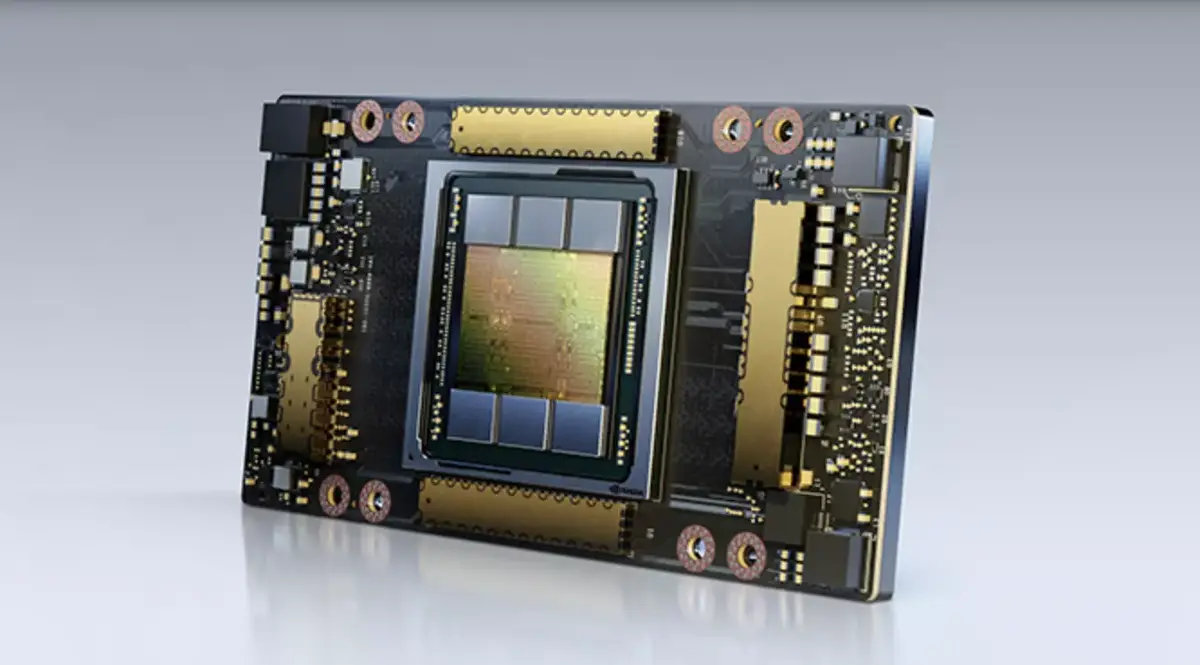

Lorsque Microsoft s'est délesté en 2019 d'un milliard de dollars pour devenir le fournisseur officiel et exclusif de services dans le cloud auprès d'OpenAI via sa plateforme Azure, l'accord incluait la construction d'un supercalculateur capable de répondre aux besoins de la firme. Afin de pouvoir entrainer de manière performante les modèles d'intelligence artificielle, Microsoft a dû concevoir une installation combinant des dizaines de milliers de GPU Nvidia A100 et H100, le tout au sein d'une structure capable de tourner à pleine capacité sans faiblir sur de longues périodes. Si le coût exact n'est pas dévoilé, Scott Guthrie, chapeautant la branche Cloud et IA chez Microsoft, évoque

un chiffre dépassant plusieurs centaines de millions de dollars.

Un challenge de taille et une structure polyvalente

L'investissement de Microsoft devait non seulement permettre de répondre aux besoins d'OpenAI (dont l'entrainement et la puissance de calcul nécessaire à ChatGPT), mais également d'offrir une structure dispersée sur plus de 60 sites apte à faire face plus largement aux exigences des technologies émergentes s'appuyant sur les algorithmes d'apprentissage automatique. Toujours selon Scott Guthrie, le supercalculateur devait également pouvoir être proposé à d'autres entités et répondre aux besoins internes, comme la mise en place de la nouvelle version de Bing :

Nous n'avons pas construit un système sur-mesure, même si cela a commencé par un projet personnalisé, mais nous l'avons conçu de manière à le généraliser afin que quiconque souhaite former un grand modèle de langage puisse tirer parti des mêmes améliorations. Cela nous a vraiment aidés à fournir un meilleur service cloud pour l'IA de manière générale.

La firme a alors mis en place en interne une petite équipe dénommée

Pit Crew(à l'image des mécaniciens chargés de régler les problèmes en urgence pendant une course automobile) afin de résoudre rapidement les divers soucis techniques et de délivrer la puissance nécessaire.

C'est vraiment une sorte de caucus, où l'on se demande "Hé, quelqu'un a une bonne idée, mettons-la sur la table aujourd'hui, et discutons-en et décidons OK, pouvons-nous gagner quelques minutes ici ? Peut-on gagner quelques heures ? Quelques jours?"

Il a ainsi fallu faire face à divers soucis, comme la pénurie de systèmes permettant de soutenir les différents câbles alimentant les machines, ce qui a mené à l'élaboration d'un système maison qui a alors pu être fabriqué en interne. Pour entrainer au mieux les algorithmes, il faut que les nombreux GPU puissent travailler ensemble avec une latence réduite grâce à une solution logicielle adaptée élaborée pour l'occasion, le tout en s'assurant que les capacités des alimentations, du refroidissement ou du réseau soient adéquates afin que le système supporte les longues charges de travail sans flancher. Microsoft compte bien optimiser encore son système et gagner en puissance et en efficacité, et ainsi permettre d'élaborer les projets qui lui seront confiés à l'avenir.

Le modèle qui impressionne le monde en ce moment (ChatGPT NDLR) est né sur le supercalculateur que nous avons commencé à construire il y a quelques années. Les nouveaux modèles seront construits sur le nouveau supercalculateur que nous formons actuellement, qui est beaucoup plus grand et permettra encore plus de sophistication.

Si certains sont sceptiques quant à l'utilité et l'avenir de ChatGPT, nul doute que d'autres solutions basées sur les algorithmes d'apprentissage automatique seront à la base d'évolutions technologiques à venir, et Microsoft entend bien pouvoir fournir les outils nécessaires à l'entraînement et la mise en place de ces futures innovations.