Protection des enfants : Apple va déployer de nouveaux outils dans iMessage, Siri, iCloud

Par Laurence - Publié le

Il s'agit de fonctionnalités sur ses plateformes visant à protéger les enfants, y compris un système capable de détecter les contenus pédo-pornographiques dans iCloud tout en préservant la confidentialité des utilisateurs. Ces dernières regroupent trois domaines : iMessage, Siri, iCloud. Ces outils feront leurs débuts d'ici la fin de l'année, dans les mises à jour d'iOS 15, iPadOS 15, macOS Monterey et watchOS 8.

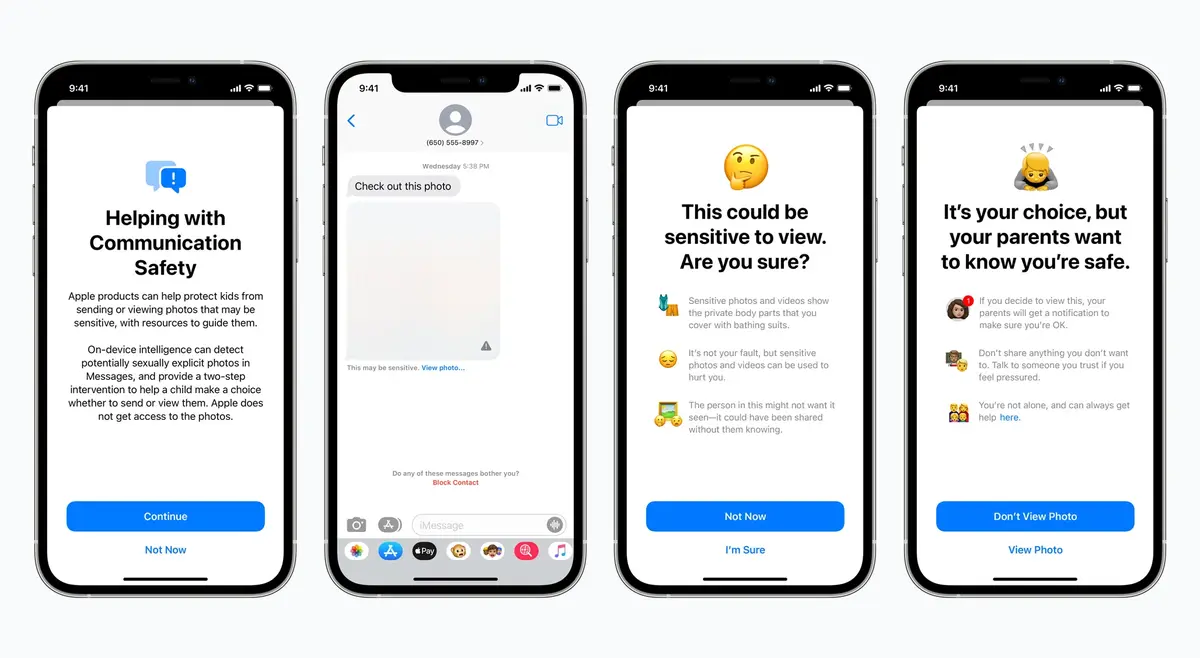

Tout d’abord, l'application iMessages sur l'iPhone, l'iPad et le Mac bénéficiera d'une nouvelle fonctionnalité de sécurité des communications pour avertir les enfants et leurs parents lors de la réception ou de l'envoi de photos sexuellement explicites. Apple a déclaré que l'application Messages utilisera l'apprentissage automatique pour analyser les pièces jointes , et si une photo est jugée sexuellement explicite, la photo sera automatiquement floue et l'enfant en sera averti.

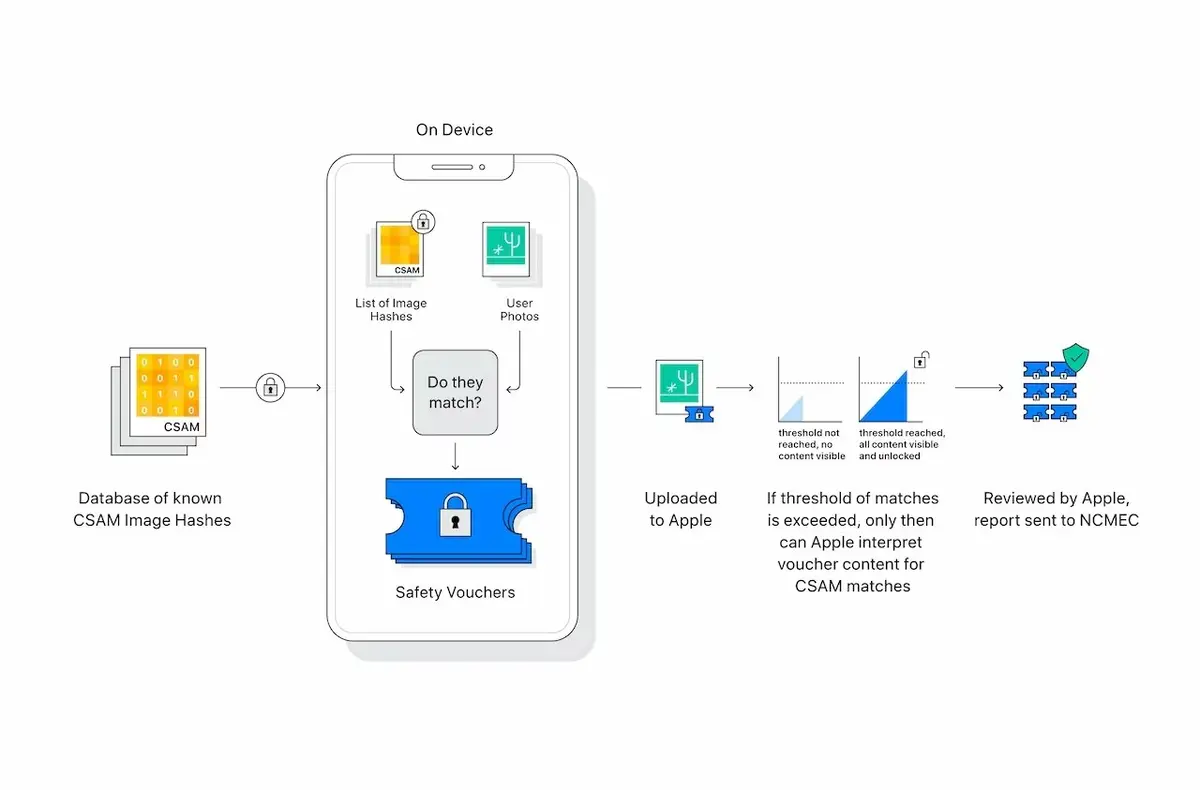

A partir de cette année (avec iOS 15 et iPadOS 15), Apple sera en mesure de détecter les images contenant des caractéristiques d'abus sexuel sur mineur (Child Sexual Abuse Material -CSAM) stockées dans Photos sur iCloud, ce qui permettra à Apple de signaler ces cas au National Center for Missing and Exploited Children (NCMEC), une organisation à but non lucratif qui travaille en collaboration avec les organismes américains d'application de la loi. Apple insiste d'ailleurs sur le fait que l'analyse se fera uniquement sur les photos stockées sur iCloud et non sur l'iPhone.

La technologie, appelée

NeuralHash, permet d’analyser une image.

L’objectif principal est de s'assurer que des images identiques et visuellement similaires donnent le même code, tandis que les images différentes les unes des autres entraînent des hachages différents, a précisé la firme dans un nouveau livre blanc Protections étendues pour les enfants.

Enfin, ces outils seront étendus dans Siri et Search, toujours dans le but d'améliorer la sécurité des enfants et de leurs parents en ligne. Pour Siri il sera possible de demander de l'aide ou comment signaler un cas suspect et obtenir de l'aide dans des situations dangereuses. Siri donnera alors conseils et ressources afin de gérer au mieux. Du côté de la recherche, en cas de requêtes sur des contenus pédophiles, les utilisateurs seront informés

que l'intérêt pour ce sujet est nuisible et problématique, et il leur sera fourni des ressources de partenaires pour obtenir de l'aide sur ce problème.

Ce système est présenté comme une technologie pour prévenir les crimes sexuels mais soulève des questions évidentes en matière de confidentialité, de vie privée ou de surveillance de millions de téléphones. Comme le souligne Matthew Green,

ce type d'outil peut être une force pour traquer la pédopornographie dans les téléphones. Mais imaginez ce qu'il pourrait faire entre les mains d'un gouvernement autoritaire ?Au delà, l’usage d’une telle technique peut s’avérer surprenante de la part d’Apple qui défend depuis toujours la vie privée, refusant de débloquer des iPhone dans des affaires pénales -comme celui de San Bernardino- à moins d’en être contrainte par un juge.

Mais Apple insiste sur ce point : la surveillance et l'abus des systèmes a toujours été une de ses préoccupations principales, Cupertino affirme ainsi avoir conçu chacune de ces nouvelles fonctionnalités pour garantir la confidentialité tout en luttant contre les abus ou l'exploitation des enfants en ligne.

Expanded Protections for Children