Que collecte Apple pour améliorer Plans sur l’iPhone ?

Par Laurence - Publié le

Plans, plus précis

Dans un nouveau document sur son site web, la firme entend renforcer la précision des fonctionnalités de réalité augmentée dans l'application Plans et précise comment elle entend procéder.

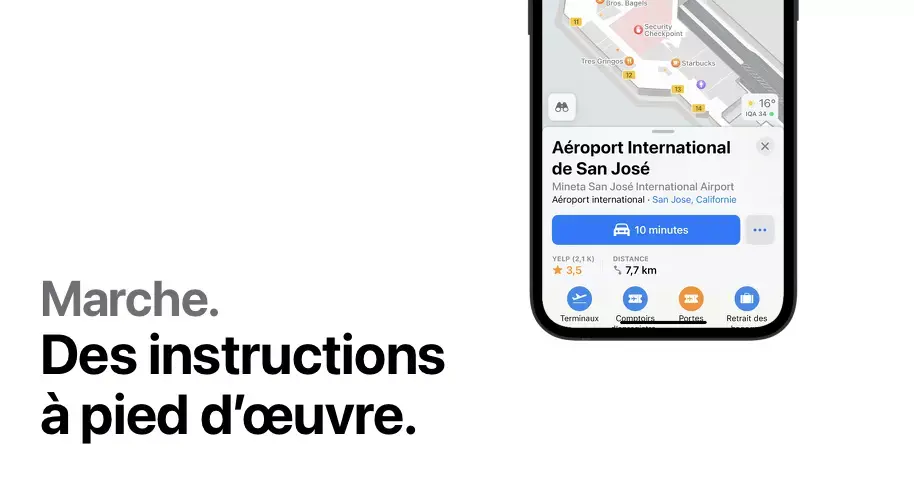

Par exemple, lors de la visualisation de directions de Marche, l'utilisateur va

prendre son iPhone pour scanner son environnement et détecter les points de caractéristiques des bâtiments à proximité et d'autres caractéristiques physiques. A cette occasion, Cupertino précise qu'aucune photo ne lui est envoyée ou stockée sur l'iPhone.

Ce dernier va détecter des

points de fonctionnalitépendant le Scan. Ces points vont permettre de représenter la forme et l'apparence des objets autour de soi (comme les bâtiments). Le système va alors passer par l'apprentissage automatique pour comparer les points de fonctionnalité aux données de référence sur les serveurs.

Cette comparaison entre les points caractéristiques et les données de référence va alors permettre d'identifier l'emplacement d'un utilisateur et de fournir des itinéraires de marche détaillés en réalité augmentée.

Mais Apple va tout de même récupérer certaines données, qui seront chiffrées et totalement anonymysées (il sera impossible de les lier à un utilisateur ou un Apple ID). La firme dit également utiliser l'apprentissage automatique sur l'appareil pour ajouter du "bruit" aux données des points caractéristiques afin d'ajouter des variations irrégulières qui empêchent toute tentative d'utiliser les points caractéristiques pour reconstruire une image à partir des données.

Notons que l'utilisation des données de réalité augmentée peut être désactivée pour empêcher Apple de les collecter via l'app Réglages > Confidentialité et sécurité > Analyses et améliorations.