Google explique comment obtenir un zoom 2x sans un second capteur

Par Didier Pulicani - Publié le

Pourtant, à l'usage, ceux qui possèdent un iPhone X ou

Plusle savent, pouvoir réaliser un zoom 2X sans perte est très pratique, même si dans le cas de l'iPhone, la second capteur est moins lumineux et pas toujours utilisé -notamment en faible lumière. Néanmoins, en plein jour, il permet de capturer plus de détails sans devoir se rapprocher de son sujet, ce qui n'est pas toujours possible, dans le cadre d'un paysage par exemple.

Pour pallier ce manque, Google a développé une technologie assez inédite : elle fait

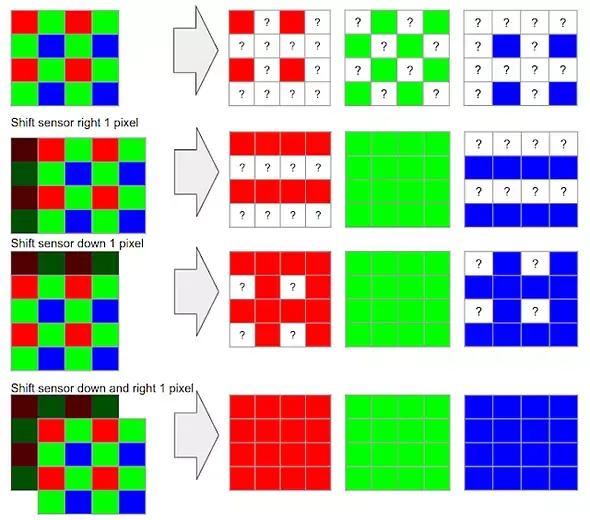

vibrerson capteur principal. La méthode utilise en fait les petites secousses de votre main lorsque vous prenez la photo, ce qui va permettre de capturer la scène avec un angle légèrement différent et donc, de récupérer davantage d'informations. Le stabilisateur optique vient ensuite corriger les mouvements histoire que le décalage entre chaque cliché soit mieux maîtrisé -c'est très astucieux ! D'ailleurs, si l'appareil est monté sur un trépied (donc, très stable), c'est la stabilisation optique qui va provoquer l'essentiel des vibrations.

Ensuite, Google effectue un travail logiciel : la résolution de l'image est augmentée artificiellement (comme lorsqu'on effectue un zoom numérique), et les différents clichés vont alors être alignés sur la grille en fonction de leur inclinaison. Chaque pixel va ensuite être calculé en fonction des différentes images, ce qui va permettre d'augmenter

artificiellementla résolution initiale mais en gagnant en informations. Mieux, cela va également permettre de réduire le bruit numérique sans devoir appliquer d'algorithmes dédiés.

A l'arrivée, Google estime pouvoir obtenir des images équivalentes à un zoom optique 2X voire 3x sans perte de qualité. Evidemment, cette technique reste limitée et dépend encore beaucoup de la résolution du capteur. Par ailleurs, la présence d'un second capteur reste plus rapide (moins de traitement) et pourrait permettre d'obtenir un zoom encore plus élevé avec ce type de technologie. Enfin, n'oublions pas que la création de scène 3D, comme ARKit, est plus aisée avec un second capteur, même si l'on s'en sort avec une optique unique -ARKit fonctionne très bien sur l'iPad.

Enfin, pour le mode portrait, Google n'est pas le premier à démontrer que détacher le sujet est largement faisable avec un seul capteur (en utilisant l'autofocus et avec une bonne dose d'IA quand-même), on a d'ailleurs hâte de voir si Apple y parviendra aussi bien sur l'iPhone XR, lui-aussi dénué de second capteur. A se demander si une optique supplémentaire offrant un zoom de seulement 2X est vraiment utile...