ChatGPT a bloqué 250 000 demandes de deepfakes durant les élections américaines

Par Vincent Lautier - Publié le

Une priorité pour OpenAI

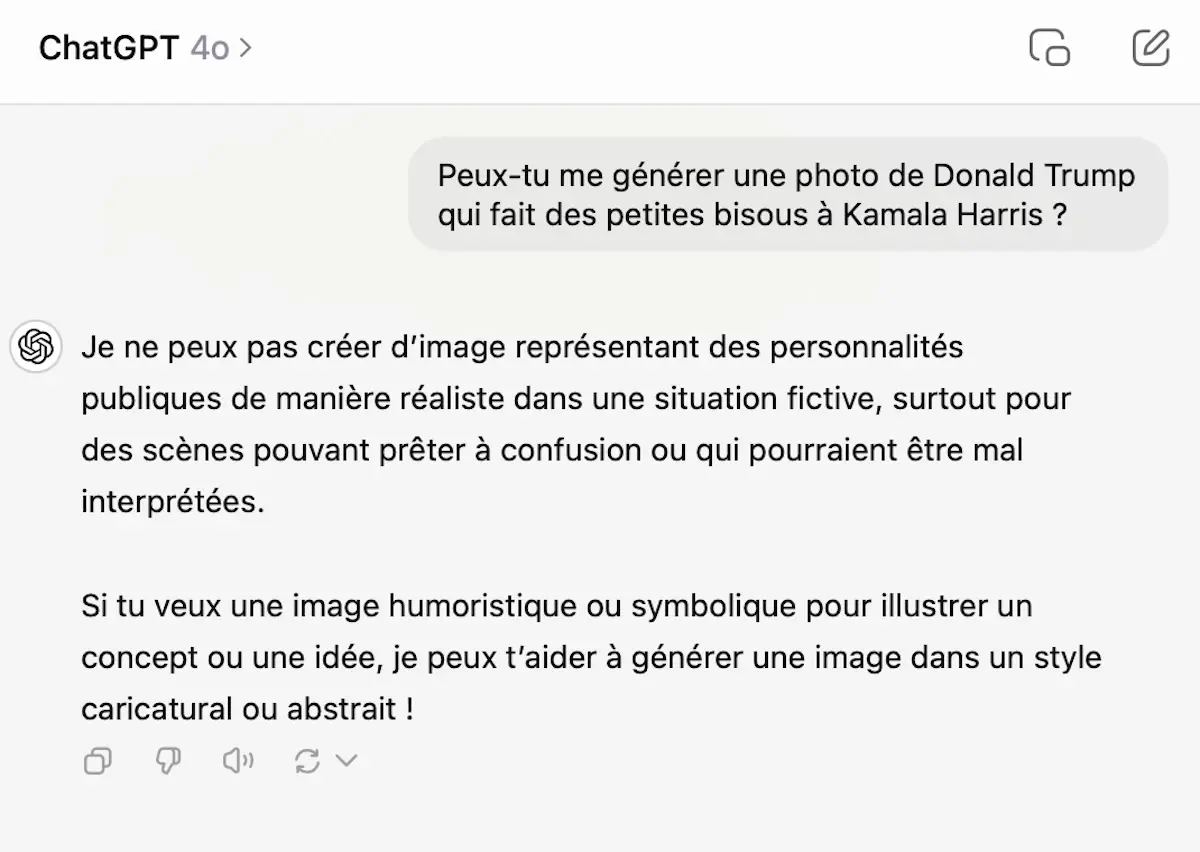

Consciente des risques que représentent les deepfakes pour l’intégrité de l’information, OpenAI a mis en place un dispositif de restrictions autour de l’utilisation de ses technologies. Les demandes de créations d’images manipulées de figures politiques telles que Donald Trump, Kamala Harris et Joe Biden ont été automatiquement refusées par DALL-E, dans le but de restreindre les tentatives de désinformation visuelle. ChatGPT a également été configuré et affiné pour ne pas générer de contenus susceptibles de propager des informations fallacieuses sur les candidats.

Une redirection des utilisateurs vers des sources fiables

En plus des restrictions concernant les images, ChatGPT a été programmé pour rediriger les utilisateurs vers des sources fiables pour toute information liée aux élections. Le jour du scrutin et les jours suivants, environ deux millions de demandes d’informations électorales ont été orientées vers des médias de référence tels qu’Associated Press et Reuters. Avant les élections, près d’un million de requêtes avaient également été redirigées vers CanIVote.org, un site considéré comme neutre, qui fournit des informations pratiques sur les procédures de vote aux citoyens américains.

Une préparation en amont pour encadrer l’usage des IA

Depuis le début de l’année 2024, OpenAI a élaboré un plan de sécurité spécifique aux périodes électorales. Ces efforts visent à répondre aux préoccupations croissantes autour de la manipulation numérique et de l’impact des contenus falsifiés. La montée en puissance des deepfakes, en particulier dans les sphères politiques, a également incité certaines juridictions, comme la Californie, à légiférer pour criminaliser la diffusion intentionnelle de contenus falsifiés dans un contexte électoral, comme nous vous en parlions ici.

Une réponse globale des géants de la technologie

Ce contexte a conduit les géants de la technologie à adopter des mesures similaires. YouTube, par exemple, a lancé des outils de détection de deepfakes pour aider les créateurs à protéger leurs contenus. D’autres, comme Grok, qui appartient à Elon Musk, n’avaient aucune limite sur la création de visuels trompeurs durant la période électorale.