Un nouvel outil Facebook pour détecter les risques de suicide (chez ses utilisateurs)

Par Laurence - Publié le

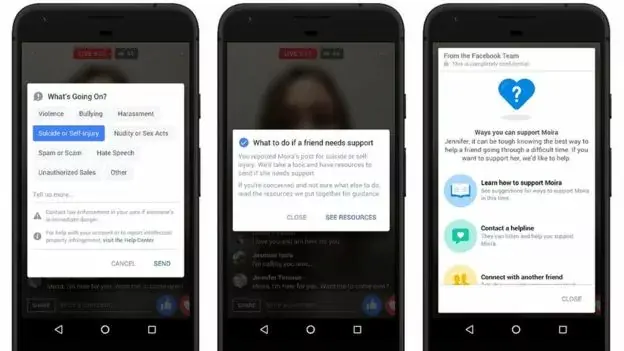

La procédure s'effectuerait en plusieurs étapes : après la détection des messages à risques, une équipe humaine serait en charge d'évaluer la situation (sans tenir compte de la confidentialité des échanges). La société offre depuis un certain temps la possibilité de signaler un contenu de nature suicidaire (voir le lien : ici).

Parmi les mots clés, on retrouvera le fait de parler de tristesse et de douleur. Il ne s'agirait pas d'examiner tous les posts où le mot apparaît (on risquerait de frôler l'overdose) mais des associations de mots : par exemple le fait de prendre des nouvelles, l'état de tristesse et de démotivation, le fait d'être inquiet ou bien la récurrence des posts abordant ces sujets.

Même si l'intention est louable, ce système va très loin dans l'ingérence dans la vie privée ou le secret des correspondances, ce qui pourrait également soulever d'autres problèmes éthiques. En outre, Mark Zuckerberg a également annoncé qu'il travaillait sur un algorithme capable d'identifier des contenus terroristes.

Source