Les Animojis qui fonctionnent sans caméra True Depth ? Pas si vite !

Par Didier Pulicani - Publié le

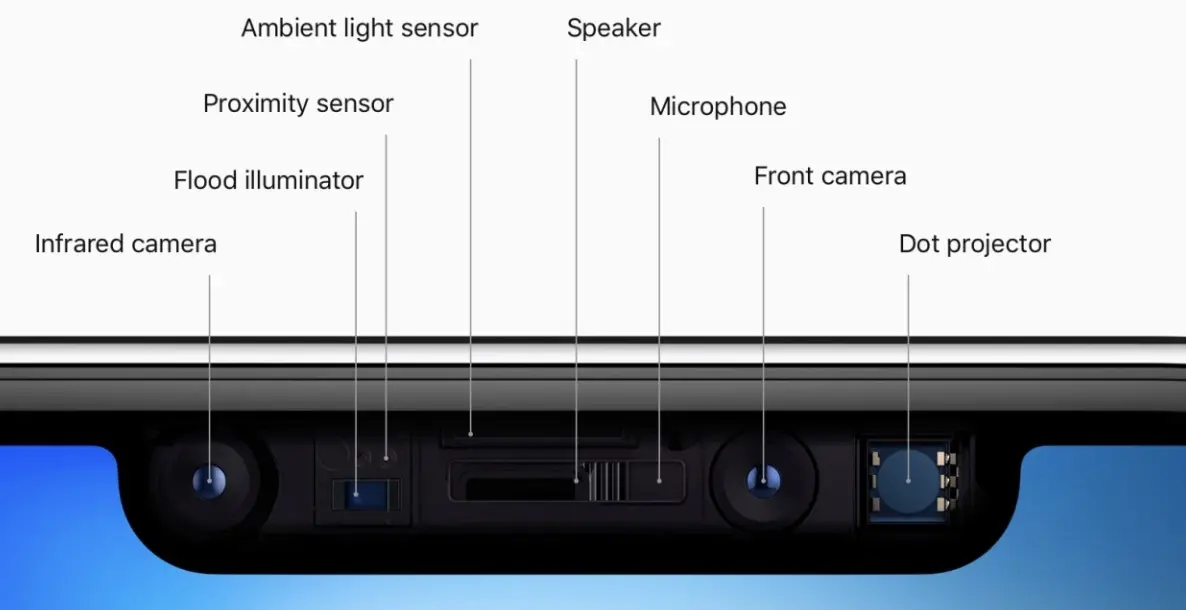

Pour appuyer sa démonstration, Marques Brownlee cachait avec son doigt les capteurs situés sur la partie gauche, qui contiennent la caméra infra-rouge, et quelques capteurs de proximité/éclairage, comme on peut le voir ici :

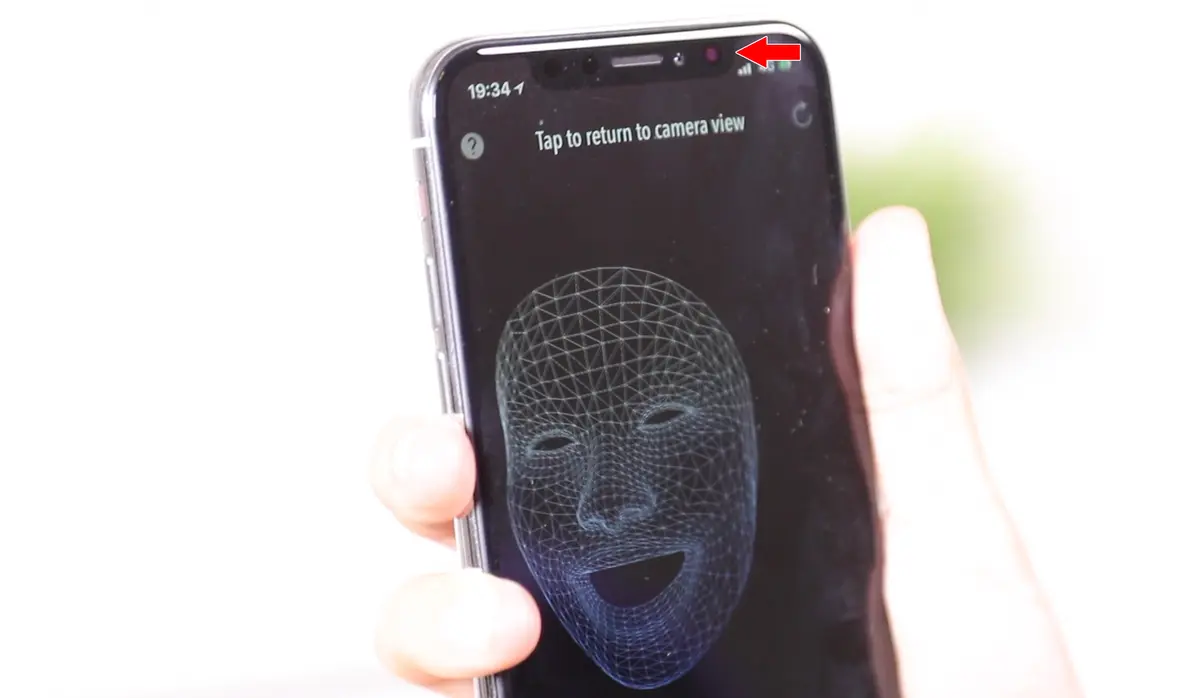

Effectivement, on a fait le test, les animations continuent de fonctionner, même sans la

caméra True Depth, cette appellation d'Apple qui comprend en réalité la caméra frontale, et tous les capteurs connexes, qui permettent de modéliser précisément votre visage. Si tel est le cas, la Pomme ne ferait donc rien de plus que de simuler la 3D, façon Snapchat : chats entre ami·e·s et ses fameux effets. Cette thèse est étayée par le fait que les Animojis -contrairement à Face ID- ne fonctionnent pas dans le noir, l'utilisation de la caméra frontale semblant donc nécessaire aux animations.

Sauf que... durant nos tests, tout ne fonctionne pas parfaitement si l'on cache vraiment la caméra IR du début à la fin. Certaines animations paraissent un peu moins précises, et l'on a même observé quelques saccades. Si le fonctionnement exact des animojis n'a pas (encore ?) été détaillé par Apple, la documentation précise bien que pour utiliser ARFaceTracking, il faut ces fameux capteurs additionnels. Il est donc possible qu'Apple mixe l'utilisation de la caméra IR et RGB pour obtenir une animation la plus précise possible, tout en économisant la batterie en favorisant la caméra RGB.

Nous avons également épluché nos vidéos tournées avec Audrey et Laura et... Tadaa ! On voit effectivement bien la projection d'infra-rouge régulièrement pendant l'enregistrement des Animojis :

Même chose avec MeasureKit - AR Ruler Tape, qui utilise le même frameworks :

Bref, si ces

capteurs 3Dne semblent pas aussi indispensables qu'on aurait pu l'imaginer, ils sont bel et bien utilisés par Apple. Nos camarades de 9to5 estiment qu'Apple peut par exemple créer une première modélisation précise du visage en 3D (pour l'isoler du reste du plan par exemple), et se contenter ensuite de la caméra frontale pour les animation. Rene Richie, d'iMore, confirme d'ailleurs cette théorie, Apple lui ayant apparemment expliqué que la qualité de l'animation dépend bien de la combinaison de tous ces capteurs.

En d'autres termes, Apple aurait pu faire une version bâclée pour iPhone 8 (qui n'a pas de TrueDepth mais partage l'A11 Bionic) ou une version carrément merd*** pour iPhone 7 (qui n'a aucun des deux), mais la société serait probablement accusée d'obtenir de mauvaises performances par les mêmes personnes la critiquant pour ne pas l'avoir implémentée partout.

En pratique, cela fait longtemps que l'on sait interpréter une image 2D pour simuler un environnement 3D (comme dans Snapchat : chats entre ami·e·s), mais une vraie captation 3D assistée par des capteurs supplémentaires permet d'obtenir des résultats bien meilleurs. Certaines apps parviennent par exemple très bien à créer le fameux

Bokehavec une seule caméra, mais elles sont beaucoup moins précises qu'avec un double-capteur.