OpenAI bloque l’accès à Sora après une fuite orchestrée par des artistes mécontents

Par Vincent Lautier - Publié le

Sora d’OpenAI hacké par ses propres testeurs

OpenAI a dû suspendre l’accès à son modèle Sora après une fuite orchestrée par un groupe d’artistes mécontents. Ces testeurs, invités à expérimenter gratuitement le modèle de génération vidéo, accusent la firme de profiter de leur travail sans compensation suffisante. Pour marquer les esprits, ils ont publié un accès public temporaire au système, déclenchant immédiatement un débat et une vive polémique au sein des acteurs du secteur.

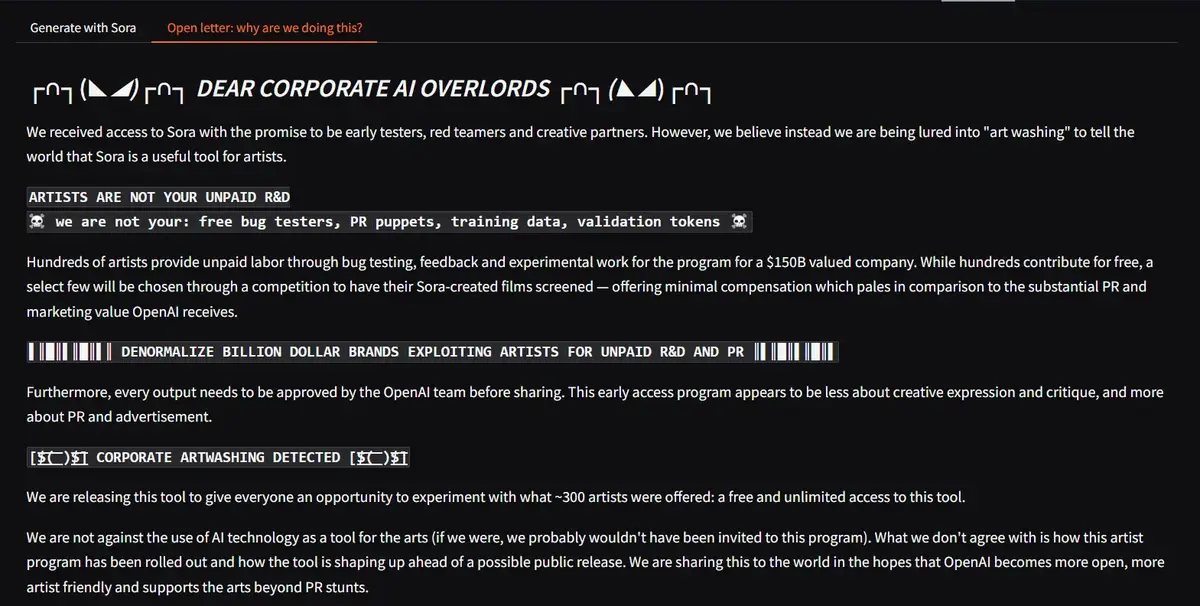

Le groupe a publié une lettre ouverte, qualifiant leur participation à ce projet de

vitrine marketing gratuitepour une entreprise valorisée à 157 milliards de dollars. Ils dénoncent un rôle dans lequel on attend d’eux qu’ils

enjoliventl’outil, sans reconnaissance réelle de leur expertise.

Un accès public qui n’a duré que trois heures

La fuite a permis au public de générer des vidéos grâce à une interface conçue par les artistes eux-mêmes. En seulement trois heures, OpenAI a coupé l’accès. Leur porte-parole, Niko Felix, a précisé que la suspension d’accès à Sora s’applique désormais à tous les utilisateurs, le temps de

mener des vérifications.

Sora, un modèle capable de produire des vidéos jusqu’en 1080p en quelques secondes, est encore en phase de recherche. OpenAI insiste sur le caractère volontaire du programme et rappelle que les artistes ont participé sans contrainte. Pourtant, ces derniers jugent l’échange inéquitable : des contributions créatives en échange de simples accès gratuits et de quelques mentions lors d’événements ne leur suffisent pas.

Une fuite qui fait écho à des tensions plus larges

Le débat dépasse le cadre de cette fuite. Il s’inscrit dans un contexte où la contestation autour des modèles génératifs d’IA est de plus en plus forte. Beaucoup d’entre eux sont entraînés à partir de données issues d’œuvres artistiques sans autorisation explicite. Bien qu’OpenAI affirme utiliser des contenus publics ou sous licence, ses déclarations restent floues et difficiles à vérifier.

Des voix critiques, comme celle de Marc Rotenberg du Center for AI and Digital Policy, estiment que cet incident illustre une problématique qui prendra de l’ampleur : le déséquilibre entre l’innovation technologique et la reconnaissance des efforts humains.

Pour OpenAI, cet incident tombe mal, surtout auprès d’une communauté d’artistes déjà en alerte face à l’exploitation de leurs œuvres. Les créateurs réclament des collaborations où leur travail est rémunéré à sa juste valeur, loin d’une dynamique incontrôlée où l’innovation prime souvent sur l’éthique.